機械学習チップの実力は? グーグルが自前データセンターでの推論処理に活用

通常の検索・写真・翻訳サービスのほか、「アルファ碁」にも

ネット検索や賢くなったグーグル翻訳のほか、世界トップレベルの囲碁棋士を破った英ディープマインドの人工知能(AI)「アルファ碁」のサーバーにも使われた米グーグルの機械学習チップ「テンソル・プロセッシング・ユニット」(TPU)。グーグルによれば、TPUを自社データセンター(DC)に導入したところ、現在使われているGPU(グラフィックス・プロセッシング・ユニット)やCPUに比べ、AI関連の推論処理が15-30倍高速化できたという。さらにエネルギー消費でも1ワット当たり30-80倍効率化されたとしている。

6月にカナダ・トロントで開催される「第44回国際コンピューターアーキテクチャーシンポジウム(ISCA2017)」に発表する論文のブレプリント版として、5日にその詳細を公開した。

ただ、こうした性能分析に対して過大評価ではないか、といった見方もある。IEEEスペクトラムの報道によれば、TPUの比較対象としているGPUが、単精度(実数の表現形式が32ビット)や倍精度(同64ビット)と、より高い精度の演算性能を持ち、その分、処理速度は相対的に遅くなる。しかも、これらはニューラルネットワークのトレーニングに適したもので通常、トレーニング済みの推論計算には必要ないという。

そもそもTPUは整数8ビット処理を行なっているため、より高度な処理を行うGPU、CPUとの比較は公正ではないのかもしれない。実際、論文の中でTPUと8ビット演算のCPUとの比較は1回しか報告がなく、その場合はTPUの方が3.5倍速かったという。

70人を超える今回の論文の共著者の一人にもなっているカリフォルニア大学バークレー校のデイビッド・パターソン名誉教授(コンピューター科学)は、シリコンバレーのコンピューター歴史博物館で5日に行われた全米工学アカデミーのシンポジウムで、「TPUは現在のCPUやGPUに比べて処理速度は10倍以内、ワット当たりの性能はさらに大きい」とその要約で述べている。

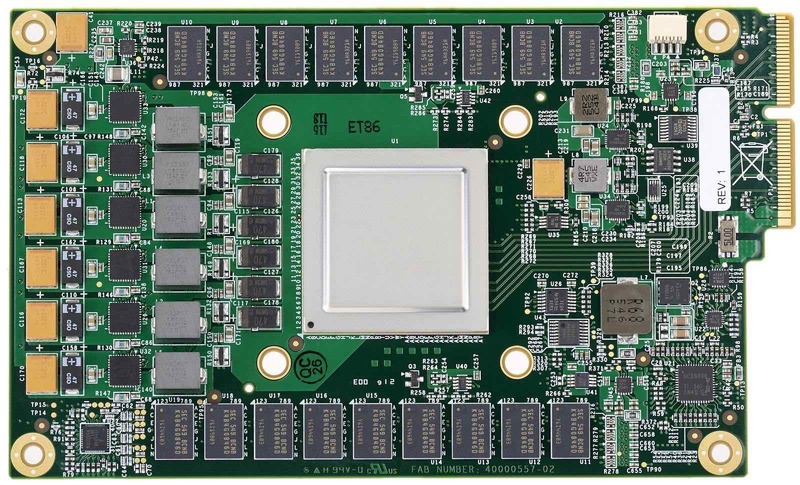

TPUはグーグルが開発したオープンソースの機械学習ソフト「テンソルフロー」と併用することで、100-1500行という小さなプログラムでアプリケーションに推論機能を加えられるという。TPU自体はサーバーコンピューターのスロットに挿入して使う基板で、グーグルが2015年以来、自社のDCに採用。検索、写真、ストリートビュー、翻訳といった一般向けのアプリケーションにも使われ、サービスの高速化や機能の高度化に貢献している。

6月にカナダ・トロントで開催される「第44回国際コンピューターアーキテクチャーシンポジウム(ISCA2017)」に発表する論文のブレプリント版として、5日にその詳細を公開した。

ただ、こうした性能分析に対して過大評価ではないか、といった見方もある。IEEEスペクトラムの報道によれば、TPUの比較対象としているGPUが、単精度(実数の表現形式が32ビット)や倍精度(同64ビット)と、より高い精度の演算性能を持ち、その分、処理速度は相対的に遅くなる。しかも、これらはニューラルネットワークのトレーニングに適したもので通常、トレーニング済みの推論計算には必要ないという。

そもそもTPUは整数8ビット処理を行なっているため、より高度な処理を行うGPU、CPUとの比較は公正ではないのかもしれない。実際、論文の中でTPUと8ビット演算のCPUとの比較は1回しか報告がなく、その場合はTPUの方が3.5倍速かったという。

70人を超える今回の論文の共著者の一人にもなっているカリフォルニア大学バークレー校のデイビッド・パターソン名誉教授(コンピューター科学)は、シリコンバレーのコンピューター歴史博物館で5日に行われた全米工学アカデミーのシンポジウムで、「TPUは現在のCPUやGPUに比べて処理速度は10倍以内、ワット当たりの性能はさらに大きい」とその要約で述べている。

TPUはグーグルが開発したオープンソースの機械学習ソフト「テンソルフロー」と併用することで、100-1500行という小さなプログラムでアプリケーションに推論機能を加えられるという。TPU自体はサーバーコンピューターのスロットに挿入して使う基板で、グーグルが2015年以来、自社のDCに採用。検索、写真、ストリートビュー、翻訳といった一般向けのアプリケーションにも使われ、サービスの高速化や機能の高度化に貢献している。

日刊工業新聞電子版2017年4月9日付