機械1台の学習を多数でシェアして効率化 英ディープマインド

データ効率10倍、大規模分散型のAIアルゴリズム開発

米アルファベット傘下の英ディープマインドは、トレーニングを行った一つの深層強化学習エージェントをもとに、トレーニングしていないほかの多数のエージェントがそれぞれの作業を効率的にこなせる分散型人工知能(AI)システムを開発した。ある領域で学習させたモデルを別の領域に適応させる「転移学習(トランスファーラーニング)」に使える。AIのトレーニング時間を短くしたり、ハードウエアのプロセッシングパワーが小さくて済んだりといった効果が期待できる。

大規模分散型の深層強化学習アーキテクチャーで、「IMPALA」と名付けた。ある学習エージェントの経験を生かして、各エージェントがタスクをこなすだけでなく、エージェント間で学習内容を同時にアップデートできる。

このアルゴリズムを搭載した機械1台をトレーニングし、データ効率はそのままに何千台もの機械へのスケールアップも可能という。

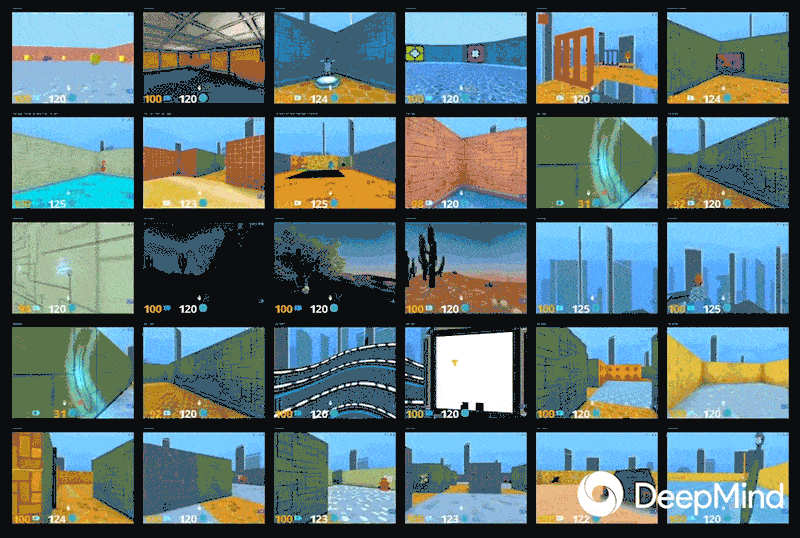

ディープマインドの深層強化学習について30のマルチタスク試験が行える「DMLab-30」や57のアタリのテレビゲームを同時に実行する「Atari-57」で試したところ、ディープマインドが2016年に発表した分散型強化学習アルゴリズム「A3C」に比べてデータ効率が10倍と、10分の1のデータ量で済んだ。

学習内容をエージェント間でシェアできることなどから性能も高く、ゲームではA3Cの2倍の得点が得られたとしている。

大規模分散型の深層強化学習アーキテクチャーで、「IMPALA」と名付けた。ある学習エージェントの経験を生かして、各エージェントがタスクをこなすだけでなく、エージェント間で学習内容を同時にアップデートできる。

このアルゴリズムを搭載した機械1台をトレーニングし、データ効率はそのままに何千台もの機械へのスケールアップも可能という。

ディープマインドの深層強化学習について30のマルチタスク試験が行える「DMLab-30」や57のアタリのテレビゲームを同時に実行する「Atari-57」で試したところ、ディープマインドが2016年に発表した分散型強化学習アルゴリズム「A3C」に比べてデータ効率が10倍と、10分の1のデータ量で済んだ。

学習内容をエージェント間でシェアできることなどから性能も高く、ゲームではA3Cの2倍の得点が得られたとしている。

2018年2月13日日刊工業新聞電子版